Og dette i en språkmodell.En morsom observasjon med ChatGPT4 er at den ikke er en stavekontroll. Fra en stavefeil i en Lumin reklame her på forumet bad jeg cgpt om å forsøke forklare hva ordet 'amkismal ' betyr. Den kom ikke opp med noe bra forslag så jeg bad den forsøke se om ordet kunne komme fra andre språk. Hvor den fant et mulig feilstavet engelsk ord som fikk Lumin DAC til å ha en negativ lydkarakter.

Derfor bad jeg den teste en hypotese at ordet muligens kunne ha sitt opphav fra det kinesiske språket, oversatt til engelsk og siden norsk. Igjen fant det flere negative karatrestikker for denne Lumin DACn.

Det morsomme er at Google translate så feilen med det samme. To første bokstavene er byttet om.

Stavefeil ser det ut som cgpt fanger mer likt hvordan vi mennesker klarer tolke feilstavete ord. Hvor start og slutt og kontekst i setning er i orden klarer vi som regel se hvilken betydning som er forsøkt utrykket.

Diverse OpenAI - sjukt imponerende AI

- Trådstarter SigbergAudio

- Startdato

Diskusjonstråd Se tråd i gallerivisning

-

Databasen er greit tilgjengelig. Selv russerne samarbeider med den.Ga den deg da riktige tall?

Arctic Ship Traffic Database

map.astd.is

I tillegg må alle skip som ønsker å bruke Nordvestpassasjen melde inn til Canada, så man kan dobbeltsjekke mot landets register, hvilket jeg ba om. "They correspond". USA aksepterer ikke at Canada har råderett, men har godtatt at USA må melde inn, for både kommersiell og militær trafikk, U-båter unntatt (regner jeg med).

Til @Asbjørn

Jeg tar utgangspunkt i din tidligere arbeidsplass, McKinsey. Selskapet slo seg opp på analyser og rådgivning og leverte meget gode (og dyre) rapporter til oppdragsgivere. Etterhvert som oppdragsmengden vokste fikk man også et sentralt arkiv over løste oppdrag, som konsulentene kunne trekke på når en ny oppgave kom.

Det var selvsagt viktig å ikke løse nye jobber for fort, for det skulle jo også timeføres, men det var bra å kunne sende ut en "etterlysning" i organisasjonen etter rapporter fra oppdrag som samsvarte med det nye. Det ga også en internsjekk og kvalitetskontroll, selvsagt, men underlettet også jobben.

Med databehandling ble dette selvsagt effektivisert, og man slapp å maskinskrive nye rapporter, cut&paste ble enkelt, og det å gi den nye rapporten en grafisk identitet som samsvarte med oppdragsgivers ga denne inntrykk av at man fikk nybrottsarbeid i hendene.

Kunnskapsnivået i organisasjonen var høyt, nettverket var suverent, arkivet var selskapets Alexandria-bibliotek - uvurderlig og utilgjengelig for andre.

Så kommer dagens AI, som potensielt kan utslette konsulentbransjen slik vi kjenner den.

Til andre, prøv flash 2.0 av Googles AI og innled en samtale (med din stemme), omkring et fagfelt du arbeider med, forsøk å trenge dypt inn i dette.

Introducing Gemini 2.0: our new AI model for the agentic era

Today, we’re announcing Gemini 2.0, our most capable AI model yet.blog.google

Scenario.

Du er i bedriftsledelsen og vil gjøre en grundig gjennomgang av et produktområde. Før var du avhengig av å enten ha ressursene internt, eller måtte engasjere eksterne konsulenter. Nå kan du la et team kjapt gjøre en gjennomgang av området og enten lage rapporten internt, eller ha et usedvanlig godt referansegrunnlag for å vurdere anbudene til eksterne konsulentselskap. Dette grunnlaget kan du skape på en ettermiddag, om du har folk som er tilstrekkelig inne i hvordan man bruker tilgjengelige verktøy.

(KI brukes nå slik av et meget stort antall virksomheter)

Du ønsker å saumfare det politiske programmet til et konkurrerende parti, men at denne gjennomgangen ikke skal være preget av eget partis fordommer. Du ønsker å finne ut hvordan du best kan appellere til bestemte velgergrupper og ønsker å legge strategier for hvordan du kan fiske stemmer fra utfordrerpartier, svakere partier, finne nye velgere og hvordan disse kan nås, og med hvilke appeller.

Dette ville du før betalt dyrt for til PR-firma, valgstrateger, men nå kan du gjøre usedvanlig dyptpløyende arbeid internt og kanskje sitte igjen med et strategisk grunnlag som gir deg betydelige fordeler i inngangen til neste valg.

(KI brukes allerede slik, selvsagt)

Dette er informasjonsbehandling, men på speed og med et omfang man ikke har hatt tilgang til tidligere, og med avprøvingsmuligheter man ikke hadde før. "McKinsey kan dette, det er nytteløst å utfordre konklusjonene i rapporten."

I neste omgang hva Hinton arbeidet med og som gjorde at han forlot Google. Når det ikke lenger er informasjonsbehandling, men -skaping. Når det "drømmes" nye muligheter og løsninger, potensielt utenfor rammene av menneskelig erkjennelse.

Time will show.

Jeg jobbet der i fem år. Det hadde man ikke. Det fantes anonymiserte metode-dokumenter, men klientkonfidensialitet forbød noe slikt som det du beskriver. Det var ikke snakk om å gjenbruke klientrapporter for VW eller Daimler-Benz på oppdrag for Volvo. Man ville blitt korsfestet offentlig. Eneste grunn til at jeg etter hvert kunne jobbe for Ford var at de hadde kjøpt Volvo, og at det jeg visste om Volvo ikke lenger var konfidensielt ovenfor Ford. Jeg hadde knapt lov til å snakke med de som jobbet med VW eller Daimler-Benz. Å dele klientmateriale mellom konkurrenter ville vært krystallklar avskjedsgrunn.Jeg tar utgangspunkt i din tidligere arbeidsplass, McKinsey. Selskapet slo seg opp på analyser og rådgivning og leverte meget gode (og dyre) rapporter til oppdragsgivere. Etterhvert som oppdragsmengden vokste fikk man også et sentralt arkiv over løste oppdrag, som konsulentene kunne trekke på når en ny oppgave kom.

Det var selvsagt viktig å ikke løse nye jobber for fort, for det skulle jo også timeføres, men det var bra å kunne sende ut en "etterlysning" i organisasjonen etter rapporter fra oppdrag som samsvarte med det nye. Det ga også en internsjekk og kvalitetskontroll, selvsagt, men underlettet også jobben.

Med databehandling ble dette selvsagt effektivisert, og man slapp å maskinskrive nye rapporter, cut&paste ble enkelt, og det å gi den nye rapporten en grafisk identitet som samsvarte med oppdragsgivers ga denne inntrykk av at man fikk nybrottsarbeid i hendene.

Kunnskapsnivået i organisasjonen var høyt, nettverket var suverent, arkivet var selskapets Alexandria-bibliotek - uvurderlig og utilgjengelig for andre.

Man hadde en stab av grafiske assistenter som hadde til oppgave å omsette håndskrevne kråketær til noe som så profesjonelt ut og stemte overens med firmaets branding. De hadde en tøff jobb. (Det var loddtrekning blant assistentene på Cleveland-kontoret hver mandag. Den som tapte måtte jobbe med Manufacturing Practice den uken.)

Som en senior partner sa om firmaet: «We have no knowledge. We have some skills, but no privileged knowledge.»

Firmaets «skills» er også offentlig tilgjengelige, men det er vanskeligere enn det ser ut til. Den egentlige suksessfaktoren var at man kunne ansette smartere folk og få dem til å jobbe hardere enn hva klientene kunne. Jeg underviste basic consulting skills for Skandinavia og Øst-Europa-kontorene, og kan attestere at disse to bøkene kommer ganske nær.

Bulletproof Problem Solving - The One Skill that Changes Everything

Complex problem solving is the core skill for the 21st Century, the only way to keep up with rapid change. The book covers the seven-step approach to creative problem solving developed in leading consulting firms. By Charles Conn and Rob McLean. bulletproofproblemsolving.com

bulletproofproblemsolving.com

Når du får en AI til å følge den oppskriften for en hittil ukjent problemstilling kan vi diskutere saken på nytt.Sist redigert:

Eg har prøvd litt av det same med ChatGPT, med ulike emne (eg trur ytterpunkta er “kjønnsuttrykk i 1980-tals heavy metal” og “kinesisk utanrikspolitisk strategi”) og kjenner meg ofte plaga av ei ubehageleg evne til å snakka meg etter munnen.Selv hadde jeg en lang samtale her om dagen med Googles seneste AI om Nordvestpassasjen og fraktmulighetene i denne og generelt i Northern Passage

Det skal liksom ikkje meir enn eitt motargument til før ChatGPT gjev seg, og rosar meg for “excellent point”.- Ble medlem

- 24.08.2018

- Innlegg

- 4.620

- Antall liker

- 3.012

Å herregud å patetisk, driver dere å slår hverandre i huet med hvem som brukte internett å installerte netscape først for å "vinne" en diskusjon om AI? Hva med å bare finne frem tommestokken?

Man takker for ditt kunnskapsrike og gjennomtenkte bidrag i diskusjonen.Å herregud å patetisk, driver dere å slår hverandre i huet med hvem som brukte internett å installerte netscape først for å "vinne" en diskusjon om AI? Hva med å bare finne frem tommestokken?- Ble medlem

- 24.08.2018

- Innlegg

- 4.620

- Antall liker

- 3.012

Hvilken diskusjon? Hvem som har lengst penis?Man takker for ditt kunnskapsrike og gjennomtenkte bidrag i diskusjonen.- Ble medlem

- 27.03.2003

- Innlegg

- 3.788

- Antall liker

- 6.656

Vil nok langt på vei si meg enig i at de siste par sidene har vært mer preget av brusing med fjær enn reell diskusjon.

Jada, men erfaringen og prinsippet tilsier at generative språkmodeller sliter med en gang det handler om fakta. Den kan slumpe til å ha rett, men ofte blir det helt feil, eller så er den så vag at leseren fyller inn hullene.Databasen er greit tilgjengelig. Selv russerne samarbeider med den.

Jeg ba ChatGPT en gang om å trekke opp linjene mellom diskursorientert og dekonstruksjonistisk kvalitativ forskning, og svaret ga mening på samme måte som en studentbesvarelse der studenten husker de rette ordene, men ikke egentlig har skjønt innholdet.

Selvfølgelig er det imponerende. Men poenget med høyere utdanning, for å følge opp eksempelet, er å utdanne folk som kan gi godt resonnerte svar, ikke bare svar som virker fornuftig. Ingen LLM kan resonnere, selv om de har lært seg å «teste» svarene sine. Det er en av grunnene til at de ikke kommer til å ta over verden.

Men mange arbeidsgivere begår nå kostbare feil fordi de tror det. De sier opp ansatte i den villfarelsen at KI skal kunne gjøre jobben i stedet. Det kan den ikke, så da må de hyre folk igjen. Det er ingen som tjener på at disse feilene gjøres, men kanskje de er nødvendige for å forstå hva KI kan og ikke kan.

Du kører med en relativt gammel CPU her?

Mener jeg har opptil flere gamle servere med den type CPU. Jeg burde kanskje sette opp en testrigg.

Ja, den er ca fem år gammel. For AI er grafikkortet viktigere. Det er et like gammelt Nvidia 1080ti, en sinke etter dagens standard, med «bare» 11 GB VRAM. Det hadde ikke skadet med 24 eller 48 GB, spesielt ikke hvis man vil forsøke å generere video også, men det blir fort dyrt.Du kører med en relativt gammel CPU her?

Mener jeg har opptil flere gamle servere med den type CPU. Jeg burde kanskje sette opp en testrigg.

Poenget er at jeg kan kjøpe litt brukt og bruke ting jeg har for en testrigg.Ja, den er ca fem år gammel. For AI er grafikkortet viktigere. Det er et like gammelt Nvidia 1080ti, en sinke etter dagens standard, med «bare» 11 GB VRAM. Det hadde ikke skadet med 24 eller 48 GB, spesielt ikke hvis man vil forsøke å generere video også, men det blir fort dyrt.

Pensjonistøkonomi er ikke rigget for moderne grafikkkort og cutting edge-hardware i det store og hele. Ja, det er grenser for hvor mye jeg har tenkt å bruke på slikt også, men VRAM blir fort en begrensning. Heller 16 GB enn 12 GB, og gjerne mer om man finner noe overkommelig. Det er mye viktigere enn CPU. Den går stort sett på tomgang mens den ser på at grafikkortet jobber.Kikker etter litt eldre kort tenker jeg, mulighet for 2 eller flere GPU-er.

Ja, det er grenser for hvor mye jeg har tenkt å bruke på slikt også, men VRAM blir fort en begrensning. Heller 16 GB enn 12 GB, og gjerne mer om man finner noe overkommelig. Det er mye viktigere enn CPU. Den går stort sett på tomgang mens den ser på at grafikkortet jobber.Kikker etter litt eldre kort tenker jeg, mulighet for 2 eller flere GPU-er.

Dette kan kanskje være interessant?

How to learn to code for free at Stanford and make six figures in under 1 year

Learn to code for free and get a job at Google or Facebook by taking advantage of Stanford’s computer science curriculum onlinemedium.com

Det Stanford-programmet ser seriøst ut, men ser også ut som mye jobb. Man behøver ikke egentlig være flytende i Python eller noe annet programmeringsspråk for å leke litt med AI, men det skader ikke. Om man er interessert er det mye å plukke her også:

Introductory Programming | MIT OpenCourseWare | Free Online Course Materials

This page will help you begin to learn programming and computer science, with some suggested introductory courses on OCW.ocw.mit.edu

Om jeg skulle satt meg ned for å lære et nytt programmeringsspråk nå ville det blitt Rust, forresten. Det har noen interessante forskjeller fra C, C++, Python og røkla:

Rust Programming Language

A language empowering everyone to build reliable and efficient software. www.rust-lang.org

Sist redigert:

www.rust-lang.org

Sist redigert:

Det tør eg ikkje seia noko om, men som eg sa i ein annan tråd, det er ikkje okkult kunnskap dette her? Det er utruleg mykje bra greier ute om både matematikk, fysikk og informatikk, MIT og ein haug toppuniversitet har heile førelesingsrekkjer ute, og bøker er stort sett greitt tilgjengelege, i verste fall til prisen av ein dobbelt-LP.Dette kan kanskje være interessant?

Det desse topp-universiteta har, er vel to ting: Eit vanvittig arbeidspress som siler ut folk hardt og brutalt, og eit miljø av andre, veldig flinke folk. På master- og phd-nivå tel nok det også at ein har tilgang til veldig flinke folk og spanande prosjekt? Altså, ein må nesten vera der for at SAIL skal vera veldig mykje betre enn IFI (eller tilsvarande ved UiB, UiTø eller NTNU).

Hugsar eg dreiv å samanlikna grunnemne i matematikk, og pensum er jo det same stort sett alle stader.

Men, utan tvil, verkeleg ein kul måte å bruka pensjonist-tida på.Du forstår åpenbart ikke hva han sier. «Energien» i algoritmen handler om den stokastiske variasjonen for å riste løs algoritmen fra sub-optimale lokale minima og finne det globale minimum. Se s 11 i presentasjonen du linket til. Man forestiller seg gjeldende løsningsforslag som en kule i et berglandskap. Den forsøker å finne veien ned i dalen, punktet med lavest «energi». På vei ned kan den bli sittende fast i en grop mellom to åsrygger. Ved å øke «temperaturen» i algoritmen får man «ballen» til å sprette rundt, slik at den har en sannsynlighet for å hoppe ut av slike lokale minima og etter hvert finne bedre løsninger med lavere «energi». Underveis reduserer man «temperaturen» for å hindre at ballen spretter veggimellom, men etterhvert stabiliserer seg på laveste punkt.

Dette er eksakt hva som skjer når man lærer opp en LLM til å gjette neste ord i en setning. Lærealgoritmen er en slik stokastisk optimeringsfunksjon. Det laveste punktet, med lavest «energi», representerer beste kurvetilpasning for prediksjon, f eks hva som vil være mest sannsynlige neste ord hvis input tilsier at man befinner seg nettopp der i landskapet. Det er ingen androide der som drømmer om elektriske sauer, bare en eller annen stokastisk optimerings-algoritme (som f eks simulated annealing, SGD, eller lignende) som oppdaterer koeffisienter i store matriser (tensorer) av numeriske verdier for å gjøre en multidimensjonal kurvetilpasning for prediksjon. Anvendelsen er ren feed-forward.

Boltzmann machine - Wikipedia

en.wikipedia.org

en.wikipedia.org

Simulated annealing - Wikipedia

en.wikipedia.org

en.wikipedia.org

Stochastic gradient descent - Wikipedia

en.wikipedia.org

en.wikipedia.org

Hinton bruker begrepet «drømmer» for å beskrive fasen i den stokastiske lærealgoritmen hvor ballen hopper tilfeldig, «våken» for fasen hvor den forsøker å finne bratteste vei ned fra hvor den enn befinner seg i øyeblikket. Begge deler er i læreprosessen, ikke i anvendelsen av nettverket. Hintons store bidrag i 2006 var å bruke koblede Boltzmann-maskiner for å representere dypere nettverk enn den begrensningen som fikk meg til å droppe mitt prosjekt. Som han selv skriver i presentasjonen på s 26 var dette en katalysator for å muliggjøre bedre algoritmer for dyp læring, men det er ikke slik dagens nettverk er oppbygd.

Joda, jeg leste da også «Gödel, Escher, Bach» i sin tid. Kan jeg også anbefale Inga Strümkes «Maskiner som tenker» for en pedagogisk innføring i hva dette er og hva det ikke er?

Norli Bokhandel

www.norli.no

www.norli.no

Ditt første spørsmål handlet om mengden energi som LLM bruker og hva jeg mente om det i forhold til miljø/klima.

Hintons arbeid med Boltzmann-maskiner viser hvordan man drastisk kan redusere energiforbruket. Han kritiserer hard-crunch LLM-arbeidet nettopp fordi det er energisløsende og viser hvordan hans forskning viser vei til digital intelligens med 30watt, der LLM-modeller bruker gigawatt når de trenes.

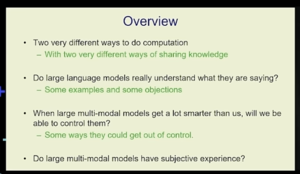

Men det viktigste med Hinton, i forhold til hvordan vi kritiserer kunstig intelligens, er hans skille mellom hva vi mennesker oppfatter som intelligens og hvordan han definerer hva digital intelligens åpner for. Dette har han gått i detalj om ved en del anledninger, på meget tilgjengelig vis her.

Verdt kikken. "Back, like, 20 years ago, people weren't interested in neural nets. And now they're not nearly scared enough of them."

Emner han tar opp:

• Ulike måter å prosessere på og hva de betyr.

• Forstår modellene hva de sier? "There's a lot of people who think they don't understand what they are saying, and those people are wrong."

• "None of us have any idea what's going to happen when they get smarter than us."

• Er de bevisste? "A lot of people ... still believe there's a big difference between these things and us. We're kind of conscious, we have subjective experience. These things are just in a computer, they don't have subjective experience. I think that's completely wrong and I think that depend upon a misunderstanding of what subjective experience is."

-

Laster inn…

Diskusjonstråd Se tråd i gallerivisning

-

-

Laster inn…