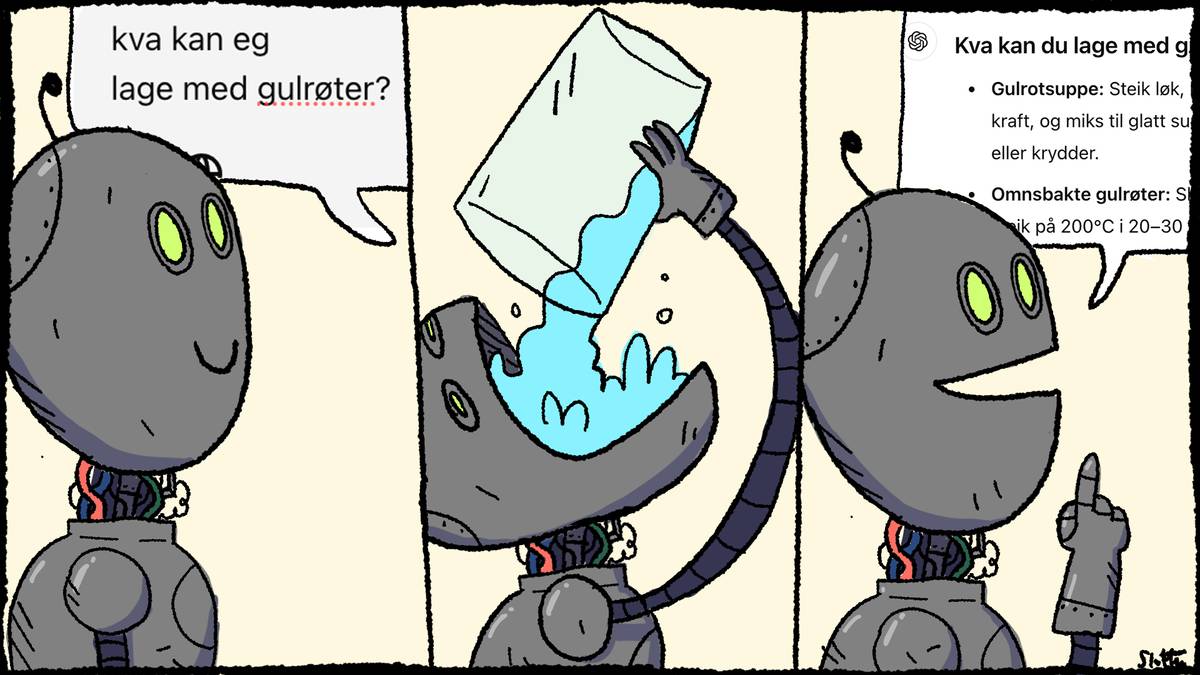

Jeg leser kronikken, skrevet av adm dir i et IT-firma, som «send oss penger».

globalconnectgroup.com

Edit: Det er en klasse av «vanskelige» problemer, NP, definert som slike hvor løpetiden for den beste kjente algoritmen øker raskere enn polynomielt med størrelsen av problemet. O(N), O(N^2) og O(N log N) er polynomiske, mens O(e^x) og O(x^x) er det ikke. Da kan man relativt enkelt løse et «mikke mus-problem», men så snart størrelsen blir mer realistisk blir løpetiden fort større enn universets levetid. Man kan vise at mange av disse er matematisk ekvivalente, NP complete. Hvis man finner en algoritme som løser ett, løser man alle. Kryptering er basert på slike, men med tilleggsegenskapen at det er lett å sjekke om svaret er riktig når det først foreligger.

Hvis Google & co kan vise at dingsen deres i det hele tatt kan brukes på noe av dette skal jeg begynne å bekymre meg, men i et scenarie hvor en hypotetisk kvantecomputer skjærer gjennom kryptering som varm kniv i smør vil det være mye i verden som plutselig er akterutseilt. Det skader vel ikke å vite hvilke dataoverføringer man selv har som er avhengige av kryptering, men stort sett alle finanstransaksjoner og annen sikker datakommunikasjon vil være kompromittert. Øyeblikkelig.

På den andre siden kan det jo tenkes at en meteor slår ned og utrydder New York City, eller at vi plutselig får kontakt med intelligente sivilisasjoner et annet sted i galaksen.

Jeg kommer ikke til å ringe kronikkforfatteren for å kjøpe et prosjekt med det første.